Это старая версия документа.

ОБЗОР WebHTTrack

Автор - Robin Catling

Создать сайт с помощью инструментов и бесплатного хостинга на Google Sites было очень просто. Беда только в том, что там нет инструментов для резервного копирования, а я не рискну оставлять единственную копию драгоценных страниц только на удалённом сервере. А представьте, что вам надо подхватить чей-то проект по созданию сайта или сменить провайдера или сервер; или, может, вам надо оптимизировать растущий трафик с помощью «зеркала» основного сайта? А может, вы выезжаете куда-нибудь, где нет интернета, и хотите взять с собой содержимое сайта? Насколько мне известно, все инструменты для этого или коммерческие, или предназначены для профессионалов, или не работают в Linux, так что без WebHTTrack не обойтись. (прим.перев.: расширение ScrapBook для Firefox является свободным и выполняет схожие задачи прямо из браузера).

Создать сайт с помощью инструментов и бесплатного хостинга на Google Sites было очень просто. Беда только в том, что там нет инструментов для резервного копирования, а я не рискну оставлять единственную копию драгоценных страниц только на удалённом сервере. А представьте, что вам надо подхватить чей-то проект по созданию сайта или сменить провайдера или сервер; или, может, вам надо оптимизировать растущий трафик с помощью «зеркала» основного сайта? А может, вы выезжаете куда-нибудь, где нет интернета, и хотите взять с собой содержимое сайта? Насколько мне известно, все инструменты для этого или коммерческие, или предназначены для профессионалов, или не работают в Linux, так что без WebHTTrack не обойтись. (прим.перев.: расширение ScrapBook для Firefox является свободным и выполняет схожие задачи прямо из браузера).

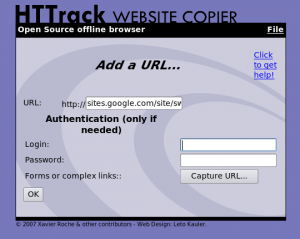

WebHTTrack — это автономный браузер, который позволяет скачать сайт и сохранить его в папке на локальном компьютере, включая всю его структуру, папки, изображения и другие файлы. Эта программа является свободной в рамках лицензии GNU General Public License. Я знал о существовании консольного варианта программы Httrack, но был приятно удивлён, обнаружив графический вариант интерфейса к ней прямо в репозиториях Ubuntu — вы можете установить её с помощью менеджера пакетов Synaptic или в меню «Установка/удаление…», просто введите в строке поиска webhttrack; можно также скачать deb-пакет с сайта этого проекта http://www.httrack.com. После установки в системном меню появится пункт WebHTtrack Website Copier. Этот пункт запускает ваш браузер, и в нём — WebHTtrack. Внешний вид форм, конечно, не верх совершенства, зато вам предлагается продуманный веб-интерфейс для очень мощного инструмента. Каждая задача по скачиванию сайта определяется как проект, которым потом руководствуется WebHTtrack для обновления копий сайтов и для возобновления приостановленных закачек.

В базовом варианте вам нужно только указать адрес сайта и папку назначения, и WebHTtrack позаботится об остальном — просто смотрите, как в окне, отображающем прогресс, меняется число скачанных файлов и папок. Программа сканирует страницы и все ссылки в них, создавая список страниц и файлов для скачивания. Когда процесс будет завершён, вы сможете открыть папку назначения, открыть страницу сайта с помощью браузера, и просматривать сайт, как будто он находится в сети интернет. Теоретически имеется также режим «холостого запуска» этого инструмента, который позволяет оценить число файлов и их объём, но не стоит рассчитывать на него в случае динамически генерируемых сайтов. Инструмент отлично работает с простыми сайтами, мне он помог решить вопрос с резервным копированием моего сайта на Google Sites, а также сайта моей компании. Автономный просмотр интернет-страниц в этих случаях работает великолепно.

В базовом варианте вам нужно только указать адрес сайта и папку назначения, и WebHTtrack позаботится об остальном — просто смотрите, как в окне, отображающем прогресс, меняется число скачанных файлов и папок. Программа сканирует страницы и все ссылки в них, создавая список страниц и файлов для скачивания. Когда процесс будет завершён, вы сможете открыть папку назначения, открыть страницу сайта с помощью браузера, и просматривать сайт, как будто он находится в сети интернет. Теоретически имеется также режим «холостого запуска» этого инструмента, который позволяет оценить число файлов и их объём, но не стоит рассчитывать на него в случае динамически генерируемых сайтов. Инструмент отлично работает с простыми сайтами, мне он помог решить вопрос с резервным копированием моего сайта на Google Sites, а также сайта моей компании. Автономный просмотр интернет-страниц в этих случаях работает великолепно.

Какие есть ограничения? Автономный просмотр работает для простого HTML, но вам понадобится установить соответствующие технологии веб-сервера, для того чтобы работали скрипты, Java, PHP и прочие SSI.

И, что ещё важнее, эта чрезвычайно полезная программа требует особого внимания к этическим аспектам, так что уместно ещё раз повторить моральные указания, которые команда создателей WebHTtrack постоянно подчёркивает.

Не нужно делать что-то только потому, что ты можешь это сделать…*

Никто лучше вас не проследит за чистотой ваших моральных устоев, поэтому:

- Не воруйте закрытую частную информацию

- Не скачивайте списки адресов электронной почты

- Не скачивайте закрытую информацию

Убедитесь, что у вас есть право на копирование сайта:

- Позволяют ли авторское право и лицензионное соглашение копировать страницы сайта?

- Имеете ли вы право скопировать сайт для личных целей?

- Не делайте копии сайта доступными в интернете, за исключением случая, если это прямо разрешено владельцем этого сайта.

Наконец, эта программа — не инструмент для организации атак на отказ в обслуживании или других зловредных акций;

- Не перегружайте сайты, которые вы копируете (к вопросу об уже упомянутых моральных аспектах); скачивание сайта может перегрузить его подключение к интернету, особенно если вы скачиваете слишком много динамически генерируемых страниц. С другой стороны, имейте также в виду загрузку своего канала связи и необходимое место на жёстком диске! Поэтому:

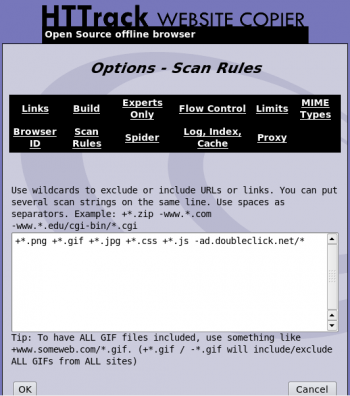

- Не скачивайте большие сайты целиком, используйте фильтры

- Не позволяйте программе открывать слишком много соединений одновременно

- Задавайте в настройках программы ограничения: ограничьте скорость скачивания, число одновременных соединений, установите лимиты на размеры и на время

- Отключайте обработку файлов robots.txt только в крайнем случае

- По возможности не скачивайте сайты в рабочее время

- Проверьте ограничения на скорость скачивания и размер при регулярном обновлении своих копий

- Прежде чем делать большие копии, сначала спросите разрешения у администратора сайта (конечно, если это не вы сами)!

Заключение

По-настоящему мощный и удобный инструмент, к тому же, весьма небольшой по размеру; подходит для решения множества самых разных задач. Не запускайте копирование бездумно; сайты работают на самых разных платформах и используют разные технологии, так что, чтобы не испытывать разочарование и не наживать проблем, прочитайте руководство на сайте проекта, у программы очень много фильтров и установок, которые стоит изучить, прежде чем начать работу в ней.